编者按:

没有什么比薅GPU羊毛更喜闻乐见。

之前有专门教程介绍谷歌资源,需要科学上网。但最近知乎上又有一套国产GPU资源的薅羊毛分享,价值上亿的高性能算力,对科研学习者完全免费。

这就是百度的AI Studio。现在,我们将这篇测评及使用分享转载如下,祝薅羊毛开心顺利。

1.AI Studio和飞桨(PaddlePaddle)AI Studio和飞桨算是后起之秀,包括我在内的很多人还不是很熟悉这一整套方案,在开薅之前,所以先简单介绍下。

1.1 AI StudioAI Studio是百度提供的一个针对AI学习者的在线一体化开发实训平台(https://aistudio.baidu.com/?fr=liangziwei)。

平台集合了AI教程, 深度学习样例工程, 各领域的经典数据集, 云端的运算及存储资源, 以及比赛平台和社区。[1]你可以把AI Studio看成国产版的Kaggle。

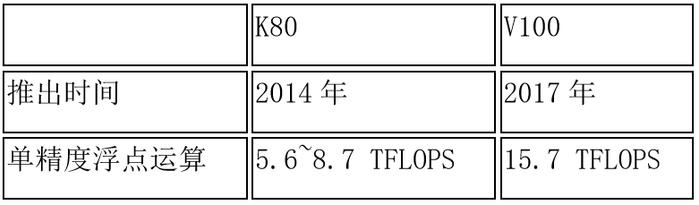

和Kaggle类似,AI Studio也提供了GPU支持,但百度AI Studio在GPU上有一个很明显的优势。Kaggle采用的是Tesla K80的GPU, AI Studio采用的是Tesla V100的GPU,那么下表对比两款单精度浮点运算性能,就能感觉v100的优势了。

明显在单精度浮点运算上,AI Studio提供的运行环境在计算性能上还是很有优势的。理论上训练速度可以提高近3倍左右。

虽然性能上好很多,但目前还是可以免费薅到,目前AI Studio提供了免费申请和运行项目奖励这两种获得算力卡的方式,最后一章我会带领大家去薅。

即使算力卡用完了(目前送得太多,根本用不完),AI Studio的CPU也是很有竞争力的。亲自用脚本测试过,AI Studio的CPU是Intel(R) Xeon(R) Gold 6148 CPU,可以说在配置上,AI Studio也是很有竞争力的。

1.2 飞桨根据官网介绍,飞桨是百度推出的 “源于产业实践的开源深度学习平台”,致力于让深度学习技术的创新与应用更简单。

Paddle是Parallel Distributed Deep Learning的缩写,翻译过来是就是桨。和TensorFlow,Pytorch等框架一样,飞桨给开发者提供了很多常用的架构,也可以直接在包里直接加载常用的数据库,对于学习者来说,还是很方便的。

飞桨(PaddlePaddle)还是有点国产的意思,去Github可以搜到PaddlePaddle的项目,除了英文文档,还提供了中文文档,这个有时候还是挺方便的。虽然现在star比起TensorFlow还是差不少,但是感觉进展得如火如荼。

1.3 AI Studio与飞桨的生态下图是百度在4月首届 WAVE SUMMIT 2019 深度学习开发者峰会时首次对外公布的 飞桨全景图。

生态其实设计得很好,可能TensorFlow先发得太早吧,感觉飞桨追赶得很吃力。但从百度最近推广飞桨的力度来看,我猜飞桨很有可能两三年左右进入主流深度学习框架之列。

为了测试AI Studio的性能,我用最经典的MNIST数据集,在LeNet 5模型上跑,对比在GPU和CPU下在AI Studio的的性能。同时我进行了一个不算严谨的测试,我用最经典的MNIST数据集,飞桨用的MNIST数据集是60000个训练数据,10000个测试数据,Kaggle的训练集数据42000,测试集数据28000。https://aiStudio.baidu.com/aiStudio/projectdetail/45293

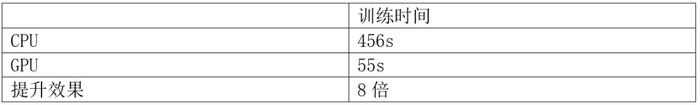

以下是AI Studio的CPU和GPU测试性能对比

GPU提升效果为11倍,因为训练过程有验证测试,而且CPU配置也太高了,所以并未达到理论上的47x的加速,但这速度还不错。

2.2 AI Studio和Kaggle对比测试测试环境:

1. Kaggle Kernel.

测试kernel https://www.kaggle.com/orange90/mnist-with-lenet-5-test-run-time. Batch_size =50,训练5000轮,使用框架TensorFlow,CNN架构是LeNet-5

2.AI Studio.

测试项目https://aiStudio.baidu.com/aiStudio/projectdetail/45293

Batch_size = 64,训练5000轮,使用框架飞桨, CNN架构是LeNet-5

AI Studio的测试结果在2.1展示了,就不再赘述了,以下是Kaggle的性能测试对比:

GPU提升效果为8倍,因为训练过程有验证测试,所以并未达到理论上的12.5x的加速。

由于架构的超参不一样,直接对比运行时间不太严谨,但从GPU提升速度的倍数上来说,AI Studio略胜一筹,况且AI Studio本来CPU就很高配了,所以理论上47x的加速可能还得打个折。

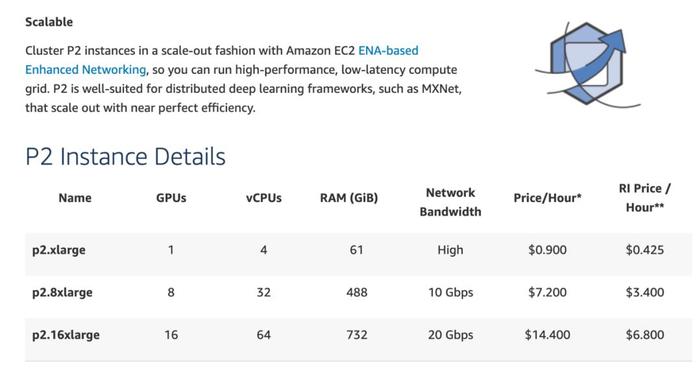

2.3 AWS也在AWS开了个instance来测试,选的是这一款配置里的p2.xlarge

直接把2.2里用到的kaggle的内核导进去了,测试结果如下:

性能上比前两者都差一点。

顺便一提,这个测试做得我脑壳痛,前期开instance,配置环境的就花了一个多小时。对于AWS新手来说,可能折腾一天,薅了十几美刀,还是没能把代码跑通。真的强烈不推荐在AWS来练习自己deep learning技能。

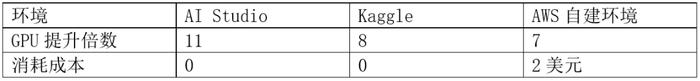

2.4. 测试总结下表总结在不同环境下的测试效果及成本:

在使用体验上,和Kaggle Kernel或者Jupyter Notebook很接近,虽然外观稍有不同,但快捷键基本一样,没有太大的不适应。除此之外,AI Studio由于在国内,页面响应比Kaggle更快,比Kaggle网络更稳定,断线重连几率要更低,毕竟断线重连要重跑还是挺蛋疼的。

不过需要提醒的是,AI Studio目前还是按运行环境启动时间来计费,是在无GPU环境下把代码写好,再开启GPU去跑。虽然AI Studio的算力卡也是送的,但也要赶紧薅起来,囤点算力资源,万一哪天百度没钱了,不送了呢?

3.羊毛来了,薅起来现在的算力卡还是很好拿的,没什么门槛,自己申请一下就拿到了,而且每天运行一次项目,又送12个小时算力,连续运行5天再加送48小时。

值得注意的是,申请的算力卡到手就是48小时,裂变之后能凑120小时,而且有效期比日常运行获取的12小时这种要长很多。

我寻思每天免费让你12小时NVIDIA v 100GPU这种事情,真的是天上掉馅饼吧。

此外,AI Studio官方也有比赛,有奖金,如果你的实力在kaggle里离拿奖金只是一步之遥,那么蹭AI Studio还没火起来之前,去AI Studio比赛应该是很好拿奖的。

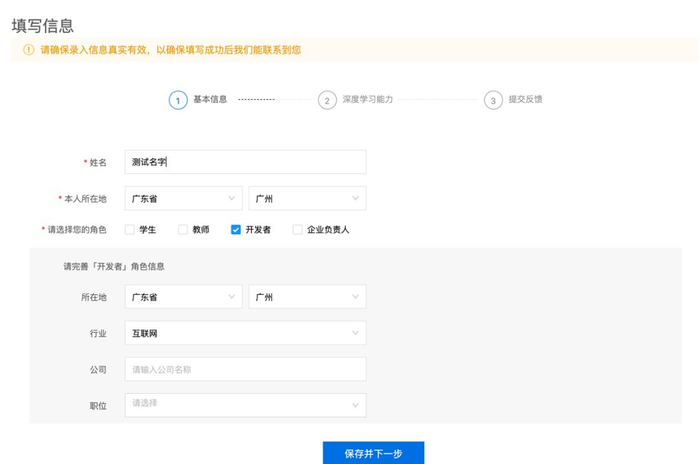

3.1 自己申请点进https://aistudio.baidu.com/aistudio/questionnaire?activityid=539

接着填写个人信息

然后就静候佳音。通过运营人员核验后,用户的邮箱将收到运营人员发送的算力邀请码:一串32位数字。

通过上面链接能申请到48小时的算力卡(有效期1个月),并且可以分裂,送给别人(稍后送上我的分裂算力卡)

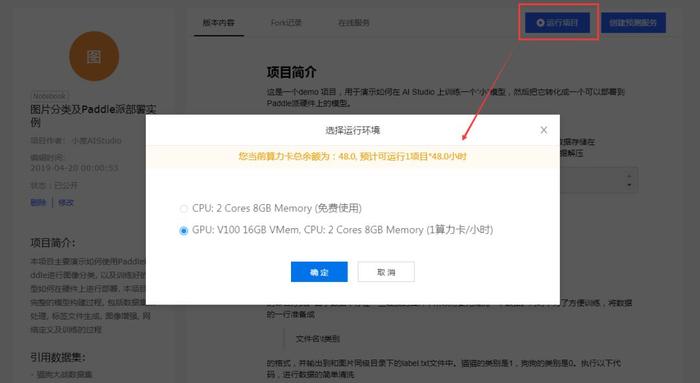

使用算力卡的方法很简单,在运行项目时选上GPU,就会开始消耗了,如下图。

这个简直了,你不仅可以运行自己的深度学习代码,测试自己的项目,而且同时还会得到算力卡。每天跑一次就可以得到12小时算力卡(有效期2天),另外算力充电计划,就是连续5天有使用算力卡,就会额外送48小时(有效期7天)。但预感这么高成本的事情应该不会持续太久,建议早薅。下面是我的算力卡奖励历史,感觉只要你用,AI Studio就送你算力,不担心算力不够。

AI Studio的算力卡有分裂功能,你申请到算力卡会有三个邀请码,你可以分享给你的朋友。我申请的算力卡有三个分裂,我每天会在评论区放一个算力卡,对羊毛贪得无厌,或者懒得申请又想马上使用的,那可要盯紧评论区了。后续我再薅到新的算力卡就会评论区更新,先到先得,希望各位多多关注本文。

3.4 比赛薅羊毛另外额外告诉大家一个可能能行的薅羊毛的方法,需要一定的实力。AI Studio也有一些常规比赛,相对于Kaggle,可能竞争会小点,如果你在Kaggle能top10%以上,来AI Studio薅类似的比赛,就很大几率拿得到奖金了。

羊毛不是天天有,该出手时就出手!

Reference:【1】https://ai.baidu.com/docs#/AIStudio_Tutorial/top?fr=liangziwei

【2】http://www.PaddlePaddle.org/?fr=liangziwei

【3】https://ai.baidu.com/forum/topic/show/943419/?fr=liangziwei

谷歌计算资源薅羊毛教程传送门:

https://zhuanlan.zhihu.com/p/59305459

作者系网易新闻·网易号“各有态度”签约作者